在业界有几种不同的流派(业界建立逻辑回归) 预测函数(线性回归模型上加了sigmoid函数): woe的计算公式: 具体可参考建模流程https://blog.csdn.net/weixin_41851055/article/details/106194063 输入数据必须是数值型数据、缺失值必须要填充、数据需要归一化或者标准化 优点: 缺点: 为什么用极大似然估计作为损失函数 训练过程中,有很多特征高的相关,会造成怎样的影响 为什么在训练过程中将高度相关的特征去掉 为什么我们选自然对数作为成本函数(符合上面性质函数很多) 注:

信贷评分卡

前言

1.逻辑回归原理

1.1 求解方式

hθ(x)=1+e−θx1其中θx=θ0+θ1x1+θ2x2+...+θnxn

对于二分类:

{p(y=1∣x,θ)=hθ(x)p(y=0∣x,θ)=1−hθ(x)

将其合并得到:

p(y∣x,θ)=hθ(x)y(1−hθ(x))(1−y)

利用极大似然估计得到(MLE):

L(θ)=i=1∏np(yi∣xi,θ)=i=1∏nhθ(xi)yi(1−hθ(xi))(1−yi)

两边同时取log:

logL(θ)=i=1∑m[yiloghθ(xi)+(1−yi)log(1−hθ(xi))]

对于

logL(θ)求最优解即是求最大值(MLE),为了用梯度下降的算法对

logL(θ)取负数,即

−logL(θ)最小值也就是

logL(θ)的最大值:

J(w)=−m1logL(θ)=−m1i=1∑m[yiloghθ(xi)+(1−yi)log(1−hθ(xi))]

根据梯度下降的求解可得

θj的更新方式:

θj:=θj−αm1i=1∑m(hθ(xi)−yi)xij1.2 逻辑回归为什么用sigmoid并且转化后的输出即为1的概率

逻辑回归的假设是y服从伯努利分布(E(X)=p,D(X)=p(1-p)),可以得出概率函数:

f(x∣p)=px(1−p)1−x=exp(η∗x+ln(1+eη))⟹η=ln(1−pp)满足条件1

η=xβ⟹(结合η=ln(1−pp))⟹E(Y)=p=g−1(η)=1+e−η1满足条件2、3

在伯努利分布中E(Y)=p表示的就是1的概率2.逻辑回归到评分卡

2.1 woe及IV

WOEi=lnp(yi0)p(yi1)=lnGGiBBi(p(yi1)为i区间坏样本占总体坏样本比例,p(yi0)为i区间好样本占总体好样本比例,越大这个分组坏样本可能性越大)

IV的计算公式:

IVi=(p(yi1)−p(yi0))∗WOEi(WOE的加权求和。IV越大,区分度越大,价值越大)2.2 逻辑回归到评分卡

ln(odds)=ln(1−pp)=θ0+θ1x1+θ2x2+...+θnxn(其中x一般是woe编码后的值,也可以是原始数据,输出即为1的概率)

以上给的是概率,有时候还需要将概率以分数形式输出,类似于蚂蚁分。具体如下:

Score总=A+B∗ln(odds)

转换步骤:

1、设定

odds=θ0时的分数

P0

2、设定

odds每增加一倍时,增加分数为

PDO

3、当

odds=θ0时的分数

P0,

odds=2θ0分数为

P0+PDO

{p0=A+Bln(θ0)p0+PDO=A+Bln(2θ0)

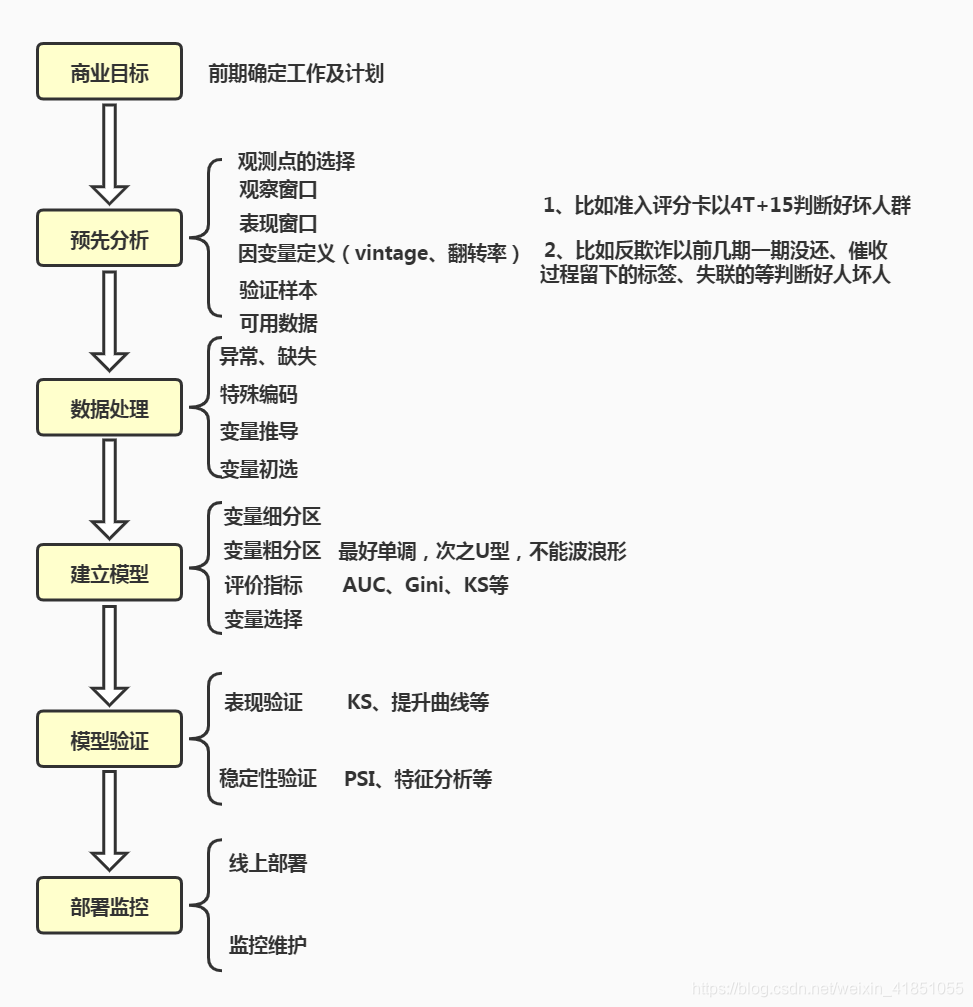

⟹{B=ln(2)PDOA=P0−Bln(θ0)2.3 评分卡的开发流程

log(odds)和评分之间具有线性关系

PSI=∑i=1nln(验证样本比例i建模样本比例i∗(建模样本比例i−验证样本比例i))当PSI<0.2样本稳定3.逻辑回归对数据的要求(比较严格)

4.逻辑回归的优缺点

5.算法需要注意的点

θj:=θj−αm1∑i=1m(hθ(xi)−yi)xij更新速度只与

xij和yi相关,与sigmoid梯度无关,如果用平方损失函数会推导出更新的速度和sigmoid函数本身很相关。sigmoid在它定义域内梯度都不大于0.25,这样训练会非常缓慢。

损失函数最终收敛的情况下,最后不会影响分类效果。但是对于可解释性会产生很大的影响。(一方面权重分给了不同的特征,另一方面可能正负相互抵消)

1、让模型的可解释性更好。2、大大提高训练速度。

因为预测函数有sigmoid,函数中含有

en,其逆运算刚好是自然对数,最终会推导出形式优美模型参数的迭代函数,而不涉及指数或对数运算。

本网页所有视频内容由 imoviebox边看边下-网页视频下载, iurlBox网页地址收藏管理器 下载并得到。

ImovieBox网页视频下载器 下载地址: ImovieBox网页视频下载器-最新版本下载

本文章由: imapbox邮箱云存储,邮箱网盘,ImageBox 图片批量下载器,网页图片批量下载专家,网页图片批量下载器,获取到文章图片,imoviebox网页视频批量下载器,下载视频内容,为您提供.

阅读和此文章类似的: 全球云计算

官方软件产品操作指南 (170)

官方软件产品操作指南 (170)