如果你从本文中学习到丝毫知识,那么请您点点关注、、评论和 欢迎大家关注微信公众号【程序猿干货铺】 Apache Spark™是用于大规模数据处理的统一分析引擎。 Run workloads 100x faster. Write applications quickly in Java, Scala, Python, R, and SQL. Combine SQL, streaming, and complex analytics. Spark runs on Hadoop, Apache Mesos, Kubernetes, standalone, or in the cloud. It can access diverse data sources. Spark 作为下一代大数据处理引擎,在非常短的时间里崭露头角,并且以燎原之势席卷业界。Spark 对曾经引爆大数据产业革命的 Hadoop MapReduce 的改进主要体现在这几个方面:

文章目录

大家好,我是爱做梦的鱼,我是东北大学大数据实验班大三的小菜鸡,非常渴望优秀,羡慕优秀的人。从5月25号我们开始了为期两个月的实习,我们需要做一个大型大数据项目,一个项目由三个学生+一个企业的项目经理完成。请大家持续关注我的专栏,我会每天更新。

专栏:大数据案例实战——大三春招大数据开发

专栏:Spark官方文档解读【Spark2.4.5中英双语】

博客地址:子浩的博客https://blog.csdn.net/weixin_43124279

一群热爱技术并且向往优秀的程序猿同学,不喜欢水文,不喜欢贩卖焦虑,只喜欢谈技术,的都是技术干货。Talk is cheap. Show me the code

Apache Spark™ is a unified analytics engine for large-scale data processing.

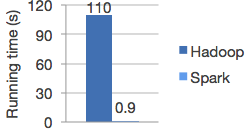

1. Speed

Apache Spark achieves high performance for both batch and streaming data, using a state-of-the-art DAG scheduler, a query optimizer, and a physical execution engine.

速度

运行工作负载的速度提高了100倍。

Apache Spark使用最新的DAG调度程序,查询优化器和物理执行引擎,可实现批处理和流数据的高性能。

Logistic regression in Hadoop and Spark

Hadoop和Spark中的逻辑回归2. Ease of Use

Spark offers over 80 high-level operators that make it easy to build parallel apps. And you can use it interactively from the Scala, Python, R, and SQL shells.

使用方便

使用Java,Scala,Python,R和SQL快速编写应用程序。

Spark提供了80多个高级算子,可轻松构建并行应用程序。 您可以从Scala,Python,R和SQL Shell交互使用它。df = spark.read.json("logs.json") df.where("age > 21").select("name.first").show() # Spark's Python DataFrame API # Read JSON files with automatic schema inference # Spark的Python DataFrame API通过自动模式推断读取JSON文件 3. Generality

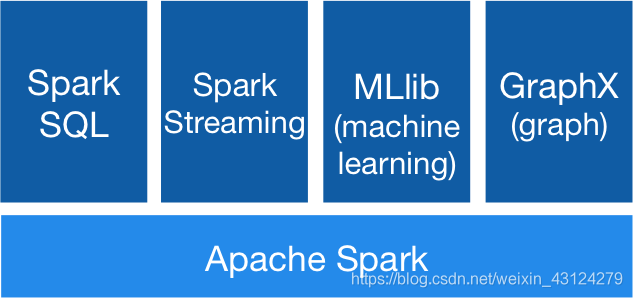

Spark powers a stack of libraries including SQL and DataFrames, MLlib for machine learning, GraphX, and Spark Streaming. You can combine these libraries seamlessly in the same application.

通用性

结合SQL、流和复杂分析。

Spark为一堆库提供了支持,包括SQL和DataFrames、用于机器学习的MLlib、GraphX和Spark Streaming。您可以在同一个应用程序中无缝地组合这些库。

4. Runs Everywhere

You can run Spark using its standalone cluster mode, on EC2, on Hadoop YARN, on Mesos, or on Kubernetes. Access data in HDFS, Alluxio, Apache Cassandra, Apache HBase, Apache Hive, and hundreds of other data sources.

运行在所有地方

Spark可在Hadoop,Apache Mesos,Kubernetes,单机或云中运行。 它可以访问各种数据源。

您可以在EC2,Hadoop YARN,Mesos或Kubernetes上使用Spark的独立集群模式运行它。 访问HDFS,Alluxio,Apache Cassandra,Apache HBase,Apache Hive和数百种其他数据源中的数据。个人总结

本网页所有视频内容由 imoviebox边看边下-网页视频下载, iurlBox网页地址收藏管理器 下载并得到。

ImovieBox网页视频下载器 下载地址: ImovieBox网页视频下载器-最新版本下载

本文章由: imapbox邮箱云存储,邮箱网盘,ImageBox 图片批量下载器,网页图片批量下载专家,网页图片批量下载器,获取到文章图片,imoviebox网页视频批量下载器,下载视频内容,为您提供.

阅读和此文章类似的: 全球云计算

官方软件产品操作指南 (170)

官方软件产品操作指南 (170)