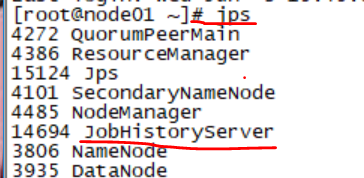

重启historyserver服务 sbin/mr-jobhistory-daemon.sh start historyserver jps查看jobhistoryserve是否启动 跑一个job任务 1.hadoop-env.sh 2.core-site.xml 3.hdfs-site.xml 4.yarn-site.xml 5.mapred-site.xml 6.mapred-env.sh

hadoop配置job日志记录

web 日志环境变量配置

mapred-site.xml

<configuration> <!-- 开启MapReduce小任务模式 --> <property> <name>mapreduce.job.ubertask.enable</name> <value>true</value> </property> <!-- 设置历史任务的主机和端口 没有配置的话 history入口不可用--> <property> <name>mapreduce.jobhistory.address</name> <value>node01:10020</value> </property> <!-- 设置网页访问历史任务的主机和端口 --> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>node01:19888</value> </property> <property> <name>mapreduce.jobhistory.done-dir</name> <value>/history/done</value> </property> <property> <name>mapreduce.jobhistory.intermediate-done-dir</name> <value>/history/done_intermediate</value> </property> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> yarn-site.xml

<!-- 开启日志聚合功能 --> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <!-- 设置聚合日志在hdfs上的保存时间 单位是秒--> <property> <name>yarn.log-aggregation.retain-seconds</name> <value>604800</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property>

打开浏览器,进入localhost:19888查看

环境变量不同的作用

文件名称

描述

hadoop-env.sh

脚本中要用到的环境变量,以运行Hadoop

mapred-env.sh

脚本中要用到的环境变量,以运行MapReduce(覆盖hadoop-env.sh中设置的变量)

yarn-env.sh

脚本中要用到的环境变量,以运行YARN(覆盖hadoop-env.sh中设置的变量)

core-site.xml

Hadoop Core的配置项,例如HDFS、MapReduce和YARN常用的I/O设置等

hdfs-site.xml

Hadoop守护进程的配置项,包括namenode、辅助namenode和datanode等

mapred-site.xml

MapReduce守护进程的配置项,包括作业历史服务器

yarn-site.xml

YARN守护进程的配置项,包括资源管理器、web应用代理服务器和节点管理器

slaves

运行datanode和节点管理器的机器列表(每行一个)

hadoop-metrics2.properties

控制如何在Hadoop上发布度量的属性

log4j.properties

系统日志文件、namenode审计日志、任务JVM进程的任务日志的属性

hadoop-policy.xml

安全模式下运行Hadoop时的访问控制列表的配置项

重要的相关配置含义

属性

含义

JAVA_HOME

设置Hadoop系统的Java安装的位置

HADOOP_HEAPSIZE

为各个守护进程分配的内存,单位为MB,如果不设置默认值是1000。

HADOOP_LOG_DIR

系统日志文件存放目录,默认在$HADOOP_HOME/logs。建议修改默认设置,使之独立于Hadoop的安装目录,这样即使Hadoop升级之后安装路径发生变化,也不会影响日志文件的位置。

HADOOP_SSH_OPTS

设置SSH选项。

<configuration> <!-- 指定集群的文件系统类型:分布式文件系统 namenode在那个集群上--> <property> <name>fs.default.name</name> <value>hdfs://node01:8020</value> </property> <!-- 指定临时文件存储目录 --> <property> <name>hadoop.tmp.dir</name> <value>/export/servers/hadoop-2.7.5/hadoopDatas/tempDatas</value> </property> <!-- 缓冲区大小,实际工作中根据服务器性能动态调整 --> <property> <name>io.file.buffer.size</name> <value>4096</value> </property> <!-- 开启hdfs的垃圾桶机制,删除掉的数据可以从垃圾桶中回收,单位分钟 --> <property> <name>fs.trash.interval</name> <value>10080</value> </property> </configuration> <configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>node01:50090</value> </property> <!-- 指定namenode的访问地址和端口 --> <property> <name>dfs.namenode.http-address</name> <value>node01:50070</value> </property> <!-- 指定namenode元数据的存放位置 --> <property> <name>dfs.namenode.name.dir</name> <value>file:///export/servers/hadoop-2.7.5/hadoopDatas/namenodeDatas,file:///export/servers/hadoop-2.7.5/hadoopDatas/namenodeDatas2</value> </property> <!-- 定义dataNode数据存储的节点位置,实际工作中,一般先确定磁盘的挂载目录,然后多个目录用,进行分割 --> <property> <name>dfs.datanode.data.dir</name> <value>file:///export/servers/hadoop-2.7.5/hadoopDatas/datanodeDatas,file:///export/servers/hadoop-2.7.5/hadoopDatas/datanodeDatas2</value> </property> <!-- 指定namenode日志文件的存放目录 --> <property> <name>dfs.namenode.edits.dir</name> <value>file:///export/servers/hadoop-2.7.5/hadoopDatas/nn/edits</value> </property> <!-- 指定一系列系统的检查点任务 --> <property> <name>dfs.namenode.checkpoint.dir</name> <value>file:///export/servers/hadoop-2.7.5/hadoopDatas/snn/name</value> </property> <property> <name>dfs.namenode.checkpoint.edits.dir</name> <value>file:///export/servers/hadoop-2.7.5/hadoopDatas/dfs/snn/edits</value> </property> <!-- 文件切片的副本个数--> <property> <name>dfs.replication</name> <value>3</value> </property> <!-- 设置HDFS的文件权限--> <property> <name>dfs.permissions</name> <value>true</value> </property> <!-- 设置一个文件切片的大小:128M--> <property> <name>dfs.blocksize</name> <value>134217728</value> </property> </configuration> <configuration> <!-- 配置yarn主节点的位置 --> <property> <name>yarn.resourcemanager.hostname</name> <value>node01</value> </property> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <!-- 开启日志聚合功能 --> <property> <name>yarn.log-aggregation-enable</name> <value>true</value> </property> <!-- 设置聚合日志在hdfs上的保存时间 --> <property> <name>yarn.log-aggregation.retain-seconds</name> <value>604800</value> </property> <!-- 设置yarn集群的内存分配方案 --> <property> <name>yarn.nodemanager.resource.memory-mb</name> <value>20480</value> </property> <property> <name>yarn.scheduler.minimum-allocation-mb</name> <value>2048</value> </property> <!-- 容器所占的虚拟内存和物理内存之比 --> <property> <name>yarn.nodemanager.vmem-pmem-ratio</name> <value>2.1</value> </property> </configuration> <configuration> <!-- 开启MapReduce小任务模式 --> <property> <name>mapreduce.job.ubertask.enable</name> <value>true</value> </property> <!-- 设置历史任务的主机和端口 --> <property> <name>mapreduce.jobhistory.address</name> <value>node01:10020</value> </property> <!-- 设置网页访问历史任务的主机和端口 --> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>node01:19888</value> </property> <property> <name>mapreduce.jobhistory.done-dir</name> <value>/history/done</value> </property> <property> <name>mapreduce.jobhistory.intermediate-done-dir</name> <value>/history/done_intermediate</value> </property> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

设置JAVA_HOME

本网页所有视频内容由 imoviebox边看边下-网页视频下载, iurlBox网页地址收藏管理器 下载并得到。

ImovieBox网页视频下载器 下载地址: ImovieBox网页视频下载器-最新版本下载

本文章由: imapbox邮箱云存储,邮箱网盘,ImageBox 图片批量下载器,网页图片批量下载专家,网页图片批量下载器,获取到文章图片,imoviebox网页视频批量下载器,下载视频内容,为您提供.

阅读和此文章类似的: 全球云计算

官方软件产品操作指南 (170)

官方软件产品操作指南 (170)